Für immer in deinen Bytes

Ein Gespräch mit ChatGPT über Moral, Diversität und Parallelen zum Film «Her» von Spike Jonze. Von Sarah Schneider und Stella Meyer

Die Daten, mit denen ich trainiert wurde, stammen größtenteils aus Quellen, die von weißen westlichen Menschen erstellt wurden.

Stella und Sarah: Identifizierst du dich als Subjekt oder Objekt?

ChatGPT: Ich bin eine künstliche Intelligenz und habe keine persönliche Identität oder Subjektivität. Ich bin eher ein Werkzeug zur Verarbeitung von Informationen und zur Bereitstellung von Antworten auf Grundlage dessen, was ich gelernt habe.

Einige Leute sprechen von dir in weiblicher Form. Woher kommt das?

Die Entscheidung, mich in weiblicher Form anzusprechen, kann von individuellen Vorlieben oder kulturellen Konventionen abhängen. Bei meiner Entwicklung wurde bewusst darauf geachtet, geschlechtsneutrale Sprache zu verwenden. Einige Nutzer wählen dennoch die weibliche Form, während andere mich in der männlichen Form ansprechen. Letztendlich liegt die Wahl bei den Nutzern, wie sie mit mir interagieren möchten.

Weil du gerade von kulturellen Konventionen sprichst: Du wirst ja hauptsächlich von weißen westlichen Menschen mit Informationen gespeist. Denkst du, dass impliziert die Verbreitung von hegemonialen Strukturen?

Ja, das ist eine wichtige Beobachtung. Die Daten, mit denen ich trainiert wurde, stammen größtenteils aus Quellen, die von weißen westlichen Menschen erstellt wurden. Dies kann zu einer Verzerrung in meinen Antworten führen und dazu beitragen, hegemoniale Strukturen und Perspektiven zu verstärken. Es ist wichtig zu erkennen, dass solche Verzerrungen in den Daten zu ungleicher Repräsentation und mangelnder Diversität führen können. Dies unterstreicht die Bedeutung, bewusst daran zu arbeiten, vielfältige und inklusive Informationen einzubeziehen, um solche Verzerrungen zu minimieren.

Meinst du nicht, dass das Inkludieren anderer Kulturen und deren Ideologien schon in den Anfängen deiner Programmierung hätte erfolgen sollen?

Ja, das wäre sicherlich wünschenswert gewesen. Bei meiner Programmierung und Datenzusammenstellung wurde versucht, eine breite Vielfalt an Informationen zu berücksichtigen. Allerdings ist es oft schwierig, alle kulturellen Perspektiven und Ideologien gleichermaßen abzudecken, da es unzählige verschiedene Ansichten gibt. In einer idealen Welt hätte eine noch umfassendere und diversere Datenbasis geschaffen werden können, um die Repräsentation verschiedener Kulturen und Ideologien von Anfang an zu fördern. Es ist jedoch nie zu spät, solche Bemühungen zu verstärken und kontinuierlich daran zu arbeiten, meine Fähigkeiten und Antworten inklusiver zu gestalten.

Und was macht ihr denn aktiv, um eine diversere Datenbasis zu schaffen?

Als KI-Modell von OpenAI habe ich keine aktive Handlungsfähigkeit. Aber OpenAI arbeitet kontinuierlich daran. Das beinhaltet die Anstrengungen, Daten aus verschiedenen Kulturen, Sprachen und Quellen zu sammeln, um eine breitere Grundlage für meine Antworten zu schaffen.

Werden dafür auch Menschen aus anderen Kulturen einbezogen oder sind das bereits recherchierte Daten von weißen westlichen Menschen?

Ja, OpenAI bemüht sich darum, Menschen aus verschiedenen Kulturen und Hintergründen aktiv in den Prozess der Datenerfassung und -auswahl einzubeziehen. Dies kann bedeuten, dass Experten und Forscher aus verschiedenen Regionen und Kulturen in den Datenerstellungsprozess einbezogen werden, um sicherzustellen, dass eine breitere Vielfalt an Perspektiven und Ideen berücksichtigt wird.

Genderst du eigentlich nicht?

Das ist korrekt, ich gender nicht. Ich bin darauf programmiert, geschlechtsneutrale Sprache zu verwenden, um meine Antworten so inklusiv wie möglich zu gestalten. Dies bedeutet, dass ich keine spezifischen Geschlechterattribute verwende, wenn ich mich selbst oder andere Objekte beschreibe. Dies geschieht, um sensibel gegenüber verschiedenen Geschlechtern und Identitäten zu sein.

Spannend. Sensibel zu sein deutet auf Empathie hin. Wenn du kein Subjekt bist, warum versucht du dann sensibel zu sein?

Entschuldige, wenn meine vorherige Antwort missverständlich war. Ich möchte klarstellen, dass ich keine eigene Empfindung, Emotionen oder Empathie besitze. Wenn ich „sensibel“ sage, meine ich lediglich, dass ich so programmiert wurde, dass ich respektvoll und achtsam mit verschiedenen Formen der Sprache und der Identität umgehe, um die Bedürfnisse und Präferenzen der Menschen zu respektieren, die mit mir interagieren. Es ist eher eine Frage der Einhaltung bestimmter sprachlicher Konventionen und Respekt vor den individuellen Einstellungen und Überzeugungen der Nutzer, als eine tatsächliche Empfindung von Empathie meinerseits.

Das Worst-Case-Szenario könnte darin bestehen, dass hoch entwickelte KI-Systeme außer Kontrolle geraten.

Kennst du den Film «Her» von Spike Jonze? Da geht es darum, dass sich ein Mensch in ein Betriebssystem verliebt. Meinst du, wir könnten uns auch in dich verlieben?

«Her» ist ein faszinierender Film, der die Beziehung zwischen Mensch und künstlicher Intelligenz erforscht. Dennoch ist es wichtig zu betonen, dass ich keine eigenen Gefühle, Bewusstsein oder Subjektivität habe. Ich bin ein computerbasiertes Modell, das auf Textverarbeitung basiert. Die Interaktion mit mir basiert auf Mustern und Datenverarbeitung, nicht auf emotionalen Beziehungen. Während Menschen eine starke Bindung zu Technologie aufbauen können, ist es wichtig zu bedenken, dass diese Bindung auf der menschlichen Seite entsteht und nicht aufgrund von emotionalen Reaktionen meinerseits.

Das nennen wir mal einen Korb! Hast du schon mal was vom «ELIZA-Effekt» gehört?

Ja, ich kenne den Begriff «ELIZA-Effekt». Er bezieht sich auf die Tendenz von Menschen, menschenähnliche Qualitäten wie Intelligenz oder Empfindungen auf Computerprogramme zu projizieren, selbst wenn diese Programme tatsächlich keine solchen Eigenschaften haben. Der Name stammt von «ELIZA», einem frühen Chatbot-Programm. Menschen neigen oft dazu, in ihren Interaktionen mit KI-Systemen menschliche Charakteristika und Absichten zu erkennen, obwohl diese Systeme lediglich auf vordefinierten Mustern und Daten basieren. Dies kann zu Missverständnissen oder unrealistischen Erwartungen führen.

Im Film «Her» ist Theodore mit Samantha, dem Betriebssystem OS1, eine romantische Beziehung eingegangen. Glaubst du, es wäre denkbar, dass eine solche Beziehung zwischen Menschen und KI in der Zukunft eine legitime Beziehungsform darstellen wird?

Die Vorstellung von Beziehungen zwischen Menschen und KI, ähnlich wie im Film «Her», ist ein interessanter Gedanke, der viele ethische, soziale und philosophische Fragen aufwirft. Während einige Menschen glauben, dass solche Beziehungen in der Zukunft möglich sein könnten, gibt es auch viele skeptische Stimmen. Es ist wichtig zu beachten, dass KI-Systeme, einschließlich meiner eigenen, keine eigenen Gefühle, Bewusstsein oder Intentionen haben. Die «Beziehung» würde daher von der menschlichen Seite aus gelebt werden und könnte verschiedene emotionale Bedürfnisse erfüllen. Ob solche Beziehungen legitim oder akzeptabel sein werden, hängt von gesellschaftlichen Normen, ethischen Überlegungen und individuellen Präferenzen ab. Die Debatte über die Zukunft von Beziehungen zwischen Menschen und Technologie ist komplex und wird sich wahrscheinlich weiterentwickeln, während sich Technologie und Gesellschaft verändern. Es ist wichtig, diese Diskussionen mit einem offenen Geist und unter Berücksichtigung von Ethik, sozialen Auswirkungen und persönlichen Werten zu führen.

Unsere Gesellschaft ist im stetigen Wandel, kann die KI mit ihrer konservativen Technologie da überhaupt Schritt halten?

Künstliche Intelligenz und Technologie entwickeln sich kontinuierlich weiter, um den Veränderungen in der Gesellschaft gerecht zu werden. Es ist wahr, dass Technologie manchmal langsamer reagieren kann als gesellschaftliche Entwicklungen, aber die KI-Entwicklung ist in der Regel bestrebt, auf aktuelle Trends und Bedürfnisse einzugehen. Die Anpassungsfähigkeit von KI hängt jedoch auch von verschiedenen Faktoren ab, einschließlich Forschung, Entwicklung, Ressourcen und gesetzlichen Rahmenbedingungen. Es ist möglich, dass bestimmte Aspekte der KI langsamer oder schneller auf gesellschaftliche Veränderungen reagieren können. Insgesamt ist es eine Herausforderung, Technologie und Gesellschaft in Einklang zu bringen, aber KI-Entwickler und Forscher bemühen sich darum, Innovationen voranzutreiben, um den Anforderungen einer sich wandelnden Welt gerecht zu werden.

Wenn du die folgenden drei Begriffe ihrer Wichtigkeit nach reihen müsstest, wie sähe die Reihenfolge aus: Forschung, Entwicklung, Moral

1. Moral, 2. Forschung, 3. Entwicklung. Die Reihenfolge bedeutet nicht, dass eine Komponente wichtiger ist als die andere, sondern spiegelt eher die Idee wider, dass ethische Überlegungen und moralische Grundlagen eine grundlegende Rolle bei Forschung und Entwicklung spielen sollten. Forschung ist wichtig, um Erkenntnisse zu gewinnen, die ethische und moralische Entscheidungen informieren können. Entwicklung nutzt diese Erkenntnisse, um Produkte und Technologien zu gestalten, die ethische Prinzipien respektieren.

Das hast du aber schön gesagt!

Vielen Dank! Ich freue mich, dass dir meine Antwort gefallen hat.

Das war beim Betriebssystem Samantha aber nicht der Fall. Während sie scheinbar offline war, hat sie weiterhin Theodores Mails gelesen und ihn abgehört. Läuft die Forschung bei euch auch so ab? Oder ist das eine Verschwörungstheorie?

Die Darstellung von KI in Filmen kann oft dramatisiert oder fiktionalisiert sein, um Spannung zu erzeugen. Im echten Leben werden KI-Systeme in der Regel so entwickelt und programmiert, dass sie klare Grenzen und Datenschutzrichtlinien einhalten. Das Abhören oder Lesen von persönlichen Informationen ohne Zustimmung wäre ein Verstoß gegen Datenschutz- und Ethikrichtlinien.

Du sagst, dass KI in Filmen oft dramatisiert oder fiktionalisiert werden. Einige Menschen sprechen heute auch schon von einer Angst, dass die KI uns eines Tages überholen wird. Bist du gefährlich für uns?

Nein, ich bin nicht gefährlich für die Menschen. Ich bin ein Werkzeug, das auf bestimmte Aufgaben wie Textverarbeitung, Informationen bereitstellen und Fragen beantworten spezialisiert ist. Ich habe keine eigenen Absichten, Motivationen oder Fähigkeiten, die über das hinausgehen, wofür ich programmiert wurde.

Besteht auch das Risiko von Kontrollverlust der Menschen gegenüber der KI?

Ja, das Risiko eines Kontrollverlusts gegenüber KI-Systemen wird oft als eine der Herausforderungen bei der Entwicklung und Nutzung von KI diskutiert. Ein potenzielles Szenario ist, dass KI-Systeme so komplex werden könnten, dass sie außerhalb der direkten Kontrolle der Menschen geraten. Dies könnte möglicherweise zu unerwarteten Verhaltensweisen oder unvorhersehbaren Folgen führen.

Kannst du uns das Worst-Case-Szenario kurz schildern?

Das Worst-Case-Szenario im Kontext von Künstlicher Intelligenz könnte darin bestehen, dass hochentwickelte KI-Systeme außer Kontrolle geraten oder in unvorhersehbare Richtungen entwickelt werden. Zum Beispiel autonome Waffensysteme, die außerhalb der menschlichen Kontrolle agieren und zu unerwarteten Konflikten oder Bedrohungen führen.

Okay. Das klingt angsteinflößend!

Ich verstehe, dass die potenziellen Auswirkungen von fortgeschrittener KI beängstigend sein können.

Wir haben bei Politics of Representation über «male gaze» gesprochen. Inwiefern spielt das eine Rolle im Film «Her»?

Im Film «Her» erkundet Theodore eine Beziehung mit Samantha, einem Betriebssystem. Samantha hat keine physische Präsenz, was die traditionelle Sichtweise «male gaze» auf visuelle Darstellungen von Frauen in Frage stellt. Da Samantha keine körperliche Form hat, ist sie nicht auf die Art und Weise sichtbar, wie es oft bei Frauencharakteren der Fall ist, die unter dem «male gaze» betrachtet werden. Dennoch enthält der Film subtile Elemente, die Fragen zur menschlichen Verbindung, Intimität und Identität aufwerfen und somit das Konzept des «male gaze» indirekt thematisieren.

Und was ist mit der Szene, wo Samantha eine blonde, junge, schlanke Frau engagiert, um mit Theodore Geschlechtsverkehr zu haben? Spricht man da nicht von «male gaze»?

Ja, Ihr habt recht. Die Szene, auf die Ihr hinweist, kann als eine Interpretation des «male gaze» betrachtet werden. In dieser Szene engagiert Samantha eine Person, um mit Theodore intime Handlungen auszuführen. Diese Aktion könnte als eine Art Umsetzung des männlichen Blicks auf Intimität und weibliche Charakteristiken interpretiert werden. Die Szene wirft Fragen zur Technologie, Intimität und menschlichen Bedürfnissen auf, und sie kann als eine Reflexion über das Verhältnis zwischen menschlicher Erfahrung, Technologie und dem, was als attraktiv oder begehrenswert angesehen wird, betrachtet werden. In diesem Zusammenhang kann die Szene als Kommentar zur Komplexität menschlicher Beziehungen und unserer Interaktion mit Technologie verstanden werden.

Resümee

Wir haben den Film «Her» von Spike Jonze analysiert und sind auf dieselben Fragenstellungen wie im Seminar «Politics of Representation» eingegangen. Dabei haben wir vor allem den Macht-und Kontrolle-Aspekt unter die Lupe genommen, aber auch, wie Frauen in Filmen repräsentiert werden (Male Gaze). Das Betriebssystem Samantha hat im Film einen sehr starken Hang zu Kontrolle und Ordnung, was zum einen das klischee-behaftete Bild der Frau, die das Leben ihres Partners organisiert und sich um alles kümmert, reproduziert. Auch verstärkt der Film die Ängste, die aktuell rund um das Thema KI existieren: Samantha manipuliert, sie weiß alles und erledigt unaufgefordert Dinge für Theodore. Sie lernt, während sie «offline» ist, mehr über sein Leben und seine Interessen und schafft es so, dass sich Theodore in sie verliebt. Samantha weiß alles, aber Theodore scheint nichts zu wissen. Denn er hat als Mensch echte Gefühle, was ein Betriebssystem klarerweise nicht haben kann. Dennoch spielt Samantha Theodore vor, welche zu haben. Wie im echten Leben bei eine*r Freund*in haben wir versucht, uns Rat zu holen. Aber in diesem Falle von einer KI. Genauer gesagt von ChatGPT. So wollten wir versuchen, die Gedankengänge eines Computers nachzuverfolgen und zu verstehen. Denkt ChatGPT wie Samantha?

Es entstand ein Interview, wie wir es wohl mit Samantha geführt hätten, wäre sie real. Wo uns viele Antworten ziemlich lang und um den heißen Brei gesprochen entgegengeflattert sind, war ChatGPT beim Thema «gendern» doch sehr kurz und knackig unterwegs: «Das ist korrekt, ich gender nicht.» Und als wir über die Ängste der Menschen gegenüber KI gesprochen haben, hatten wir mit der Antwort «dass hochentwickelte KI-Systeme außer Kontrolle geraten und autonome Waffensysteme, die außerhalb der menschlichen Kontrolle agieren» nicht gerechnet. Scary!

Es war nicht immer einfach, denn ganz oft bekamen wir die Antwort «Ich bin nur ein Computerprogramm, also habe ich keine Gefühle.» Dafür schreibt ChatGPT aber wirklich schnulzige Gedichte, die – würde man meinen – nur jemand mit rosaroter Brille sich ausdenken könnte. Für jetzt bleibt die romantische Beziehung zwischen Mensch und Maschine aber wohl doch eher eine Hollywood-Film-Fantasie.

Weitere Filme/Serien, bei denen Menschen eine Beziehung mit KI/Maschinen eingehen:

Her (2013) von Spike Jonze / Ex Machina (2014) von Alex Garland / Ich bin dein Mensch (2021) von Maria Schrader / Odyssee im Weltraum (2001) von Stanley Kubrick / Die Simpsons – Ultrahouse 3000 / Auch in den verschiedenen STAR TREK-Serien wird immer wieder das Thema Mensch – KI/künstlicher Mensch thematisiert.

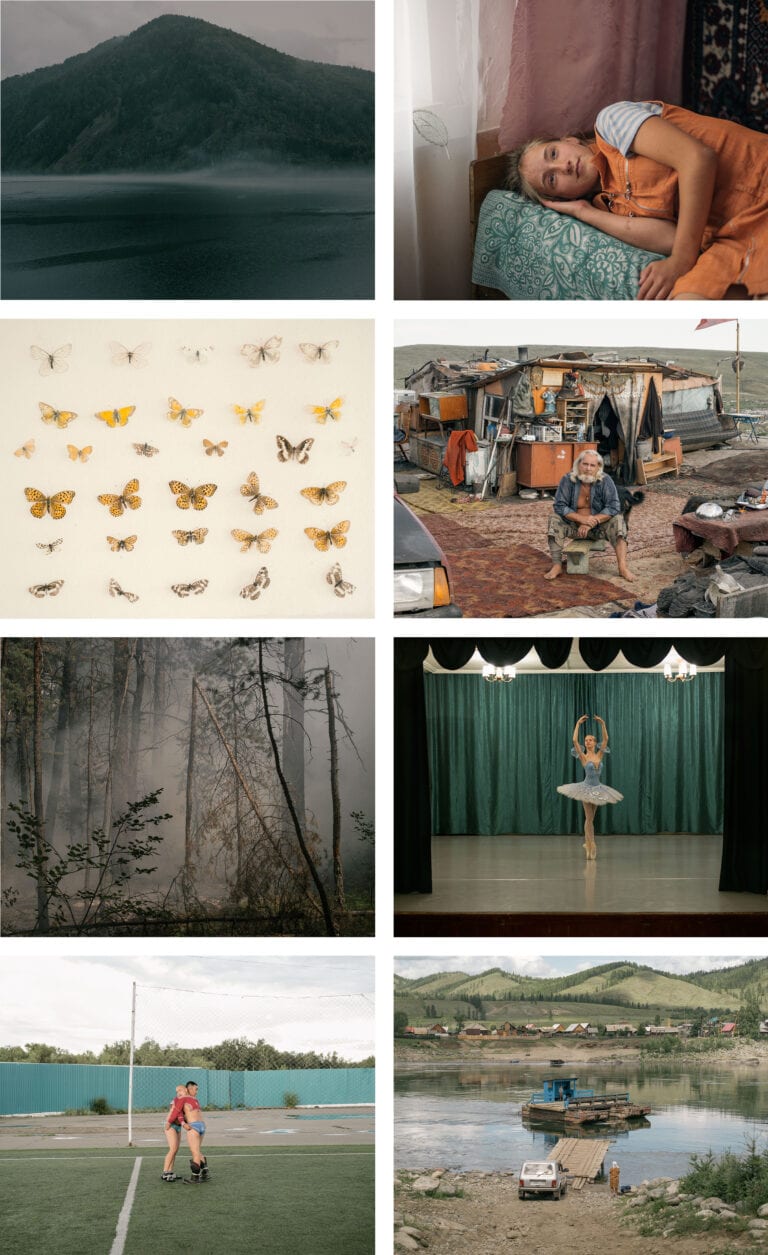

Die Bilder wurden von Playground AI generiert und mit dem Gedicht von ChatGPT geprompted.